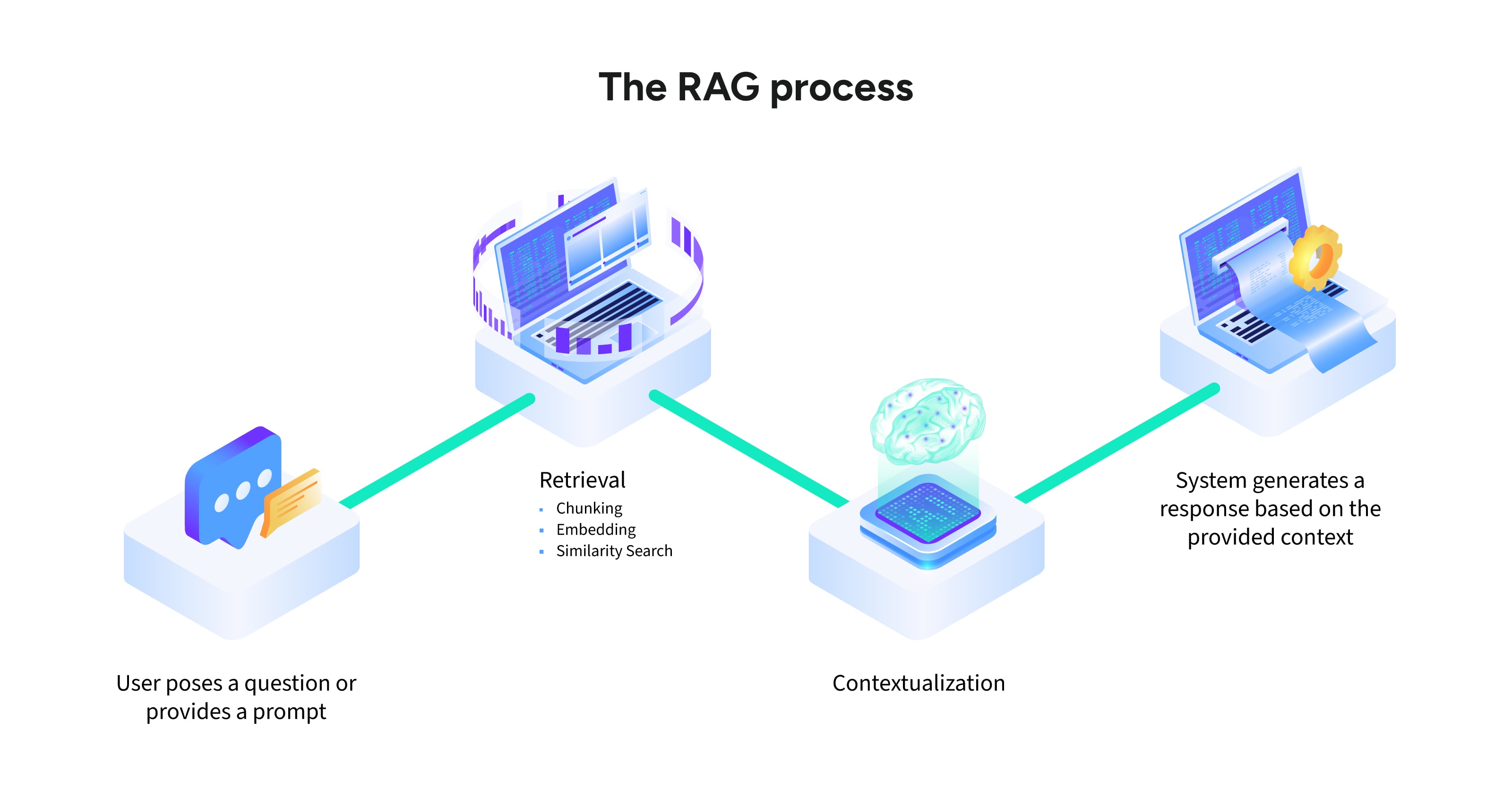

Applications concrètes de la RAG

La capacité d'adaptation de la RAG lui confère une grande valeur dans tous les secteurs d'activité et dans tous les cas d'utilisation. Voici quelques exemples :

Support client

Les chatbots d'IA alimentés par la RAG fournissent des réponses hautement personnalisées en exploitant les politiques internes, les FAQ et les données spécifiques à chaque cas. Ils minimisent les temps d'attente et améliorent la satisfaction des utilisateurs.

Lire la suite | La puissance de l'IA dans le service client

Finances

La RAG aide les analystes en leur fournissant des mises à jour en temps réel des conditions du marché, des changements réglementaires et des indicateurs de performance du portfolio. Ils peuvent ainsi réagir de manière plus stratégique sur des marchés volatils.

Création de contenu

Qu'il s'agisse de résumer de longs documents ou de créer des rapports factuels, la RAG facilite la génération de contenu efficace et précis, permettant ainsi aux équipes de se concentrer sur des tâches plus complexes.

Autonomisation des employés

Les systèmes RAG d'entreprise aident les équipes en fournissant des réponses aux questions RH, des directives de conformité et des supports de formation. La main-d'œuvre est ainsi plus autonome et les frais administratifs réduits.