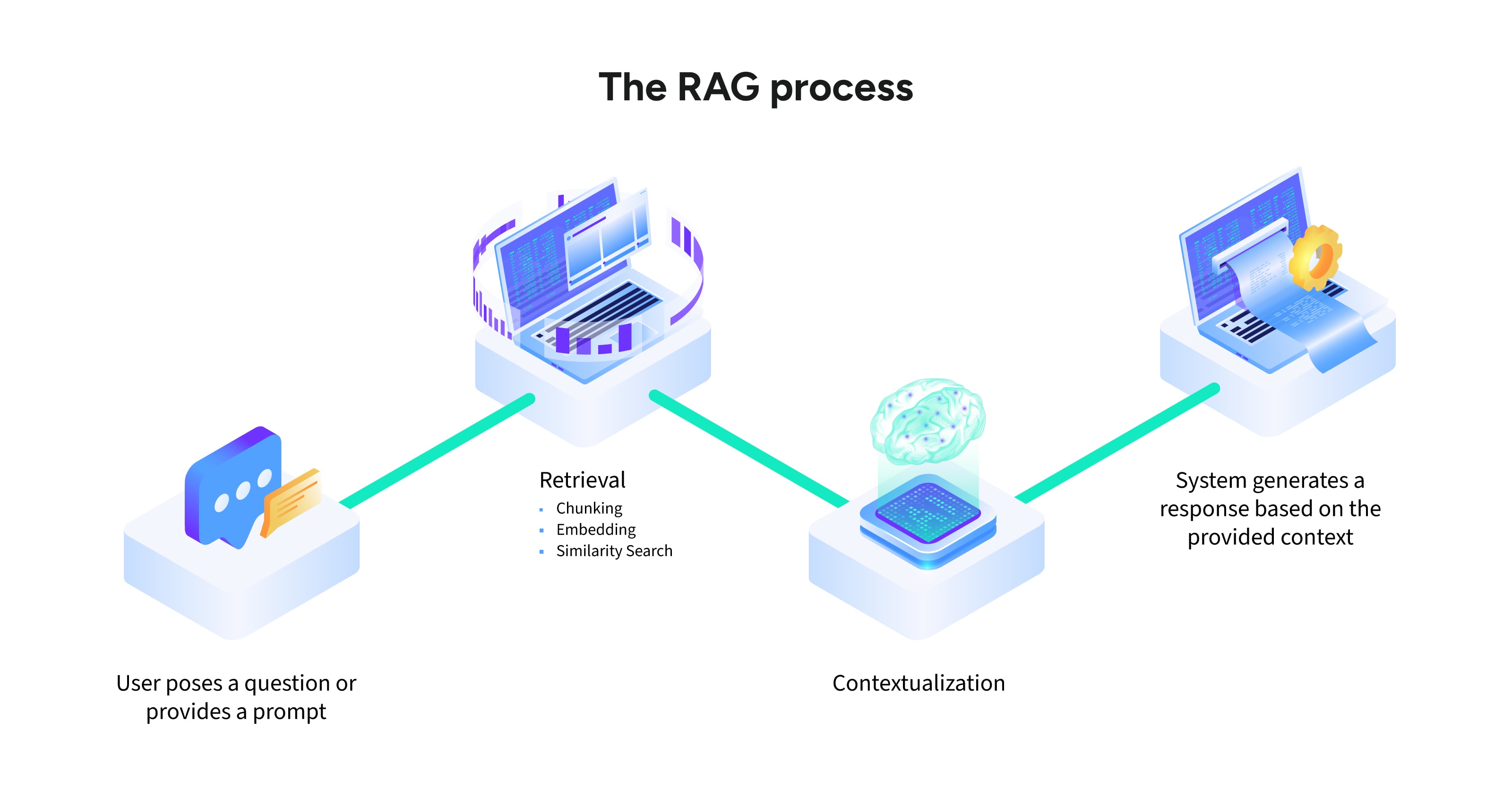

Abfrageverarbeitung

Der Prozess beginnt, wenn ein Benutzer eine Suchabfrage oder Eingabe sendet. Diese Eingabe wird analysiert und in eine maschinenlesbare Einbettung umgewandelt, die eine numerische Darstellung des Textes darstellt.

Informationsabruf

Das System identifiziert und sucht relevante Informationen aus externen Quellen wie Datenbanken, APIs oder Dokumentenspeichern ab. Dieser Schritt umfasst:

- Chunking: Das Aufteilen großer Dokumente in kleinere, handlichere Abschnitte.

- Embedding-Abgleich: Die Umwandlung von Textabschnitten in numerische Einbettungen zum Abgleich mit der Suchabfrage.

- Relevanzbewertung: Die Verwendung von Algorithmen wie der semantischen Suche, um die kontextuell relevantesten Daten zu priorisieren.

Kontextualisierung

Relevante Daten, die aus externen Quellen gesucht werden, werden an die ursprüngliche Suchabfrage angehängt, um eine umfassende, erweiterte Eingabeaufforderung zu erstellen. Dies stellt sicher, dass das LLM über genügend Kontext verfügt, um seine Antwort zu generieren.

Antwortgenerierung

Das LLM verarbeitet die angereicherte Eingabeaufforderung, um eine Antwort zu generieren, die sowohl die gesuchten Daten als auch sein vortrainiertes Wissen enthält. Dieser ausgewogene Ansatz stellt sicher, dass die Ausgaben spezifisch, genau und relevant sind.

Endausgabe

Die Antwort wird dem Benutzer präsentiert, häufig mit Verweisen oder Links zu den verwendeten Quellen. Diese Transparenz schafft Vertrauen und bietet den Nutzern tiefere Einblicke.